grep是一个很强大的命令。这里我们主要来讲使用grep命令来分析网站日志的方法和技巧。

1、合并网站日志

首先使用ls查看下待合并的日志,可以利用cat命令合并网站日志

cat *.log >example.log

#合并后缀名为log的日志文件,你也可以合并指定的日志

2.拆分我们想要的日志文件

比如拆分百度蜘蛛的日志文件

grep “Baiduspider+” example.log >baiduspider.txt

比如拆分404错误日志

grep “404″ example.log >404.txt

还可以同时拆分百度和谷歌的蜘蛛。

这里我们使用的是egrep来实现这一功能。

egrep “Baiduspider+|Googlebot” example.log >spider.txt

3、我们还可以结合awk命令来格式话我们的日志文件

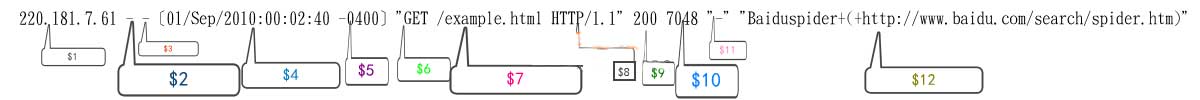

awk倾向于分析一行中的字段,我们需要来看一下网站的日志格式

我们截取百度蜘蛛访问的来源IP、时间、抓取的URL、返回码和抓取的大小。

grep “Baiduspider+” example.log |awk ‘{print $1 “\t” $4 “\t” $7 “\t” $8 “\t” $9 “\t” $10}’ >Baiduspider.txt

还可以获取独立IP,并对ip访问次数进行统计。

awk ‘{print $1}’ access.log|sort|uniq -c >ip.txt

1、合并网站日志

首先使用ls查看下待合并的日志,可以利用cat命令合并网站日志

cat *.log >example.log

#合并后缀名为log的日志文件,你也可以合并指定的日志

2.拆分我们想要的日志文件

比如拆分百度蜘蛛的日志文件

grep “Baiduspider+” example.log >baiduspider.txt

比如拆分404错误日志

grep “404″ example.log >404.txt

还可以同时拆分百度和谷歌的蜘蛛。

这里我们使用的是egrep来实现这一功能。

egrep “Baiduspider+|Googlebot” example.log >spider.txt

3、我们还可以结合awk命令来格式话我们的日志文件

awk倾向于分析一行中的字段,我们需要来看一下网站的日志格式

我们截取百度蜘蛛访问的来源IP、时间、抓取的URL、返回码和抓取的大小。

grep “Baiduspider+” example.log |awk ‘{print $1 “\t” $4 “\t” $7 “\t” $8 “\t” $9 “\t” $10}’ >Baiduspider.txt

还可以获取独立IP,并对ip访问次数进行统计。

awk ‘{print $1}’ access.log|sort|uniq -c >ip.txt

安装Squid

安装Squid Nginx/Apache日志分析脚本

Nginx/Apache日志分析脚本